工作原理

众所周知Google Drive谷歌云盘每日单个帐号流量为750G,包含上传下载,一般下载量750G是完全够用了,但是转存文件750G很多大佬都不够用.这个时候就有某大神提出了另外的思路,可以变相的突破这个上限.原理主要如下,本章节一定要仔细看清楚,理解了原理,在某个环节该做什么你才可以清楚:

1团队盘(Google Team Drive)拷贝到用户个人盘:不费流量

2团队盘(Google Team Drive):可以使用多用户上传,当然用户必须是团队盘用户,并且GoogleAPI支持服务号,可以批量生成,一个用户750G,100个用户就75T了,该够用了吧

3最后从个人用户直接从团队盘中取回个人云盘,变相实现了突破750G转存上限,当然没有无限帐号的可以丢在团队盘中也是可以用的,目前goindex和Rclone等网盘程序是支持挂载团队盘的

需要以下工具及功能如下:

- gclone用于挂载谷歌云盘并对云盘及团队盘进行操作,文件目录间的互相拷贝和自动切换帐号,当一个服务号流量达到750G的时候,会报rateLimitExceeded错误,这个时候会自动触发gclone自动切换帐号,以实现750G上限,实际上单个帐号的750G还是750G,只是帐号多了而已.

- autorclone作用主要为批量生成帐号,并将帐号批量添加至google team drive团队盘中去

- Rclone作用主要为对config文件及gclone可能存的问题进行备用互补,实际上一般用不到.

前提条件

- PC环境:系统在WIN7-SP1以上,win7及winXP下版本暂不支持,本文环境WIN10-X64

- 网络环境:全局代理一枚,不支持TCP的代理如HTTP-proxy是不可以的,SSR|tojan|v2ray这几种流行的扶墙方式均可以,需要搭配其他软件来实现;传统VPN最佳(PPTP、L2TP和IPSec),这个直接就可以上车,总之需要真正的全局代理,而不是HTTP全局.

- Google Drive一枚,可以是个人账号,只有15G空间,那么本文你只可以实现团队盘无限操作了,也可以无限的GD,有商业版,也有白嫖的教育版,可以在本站找找采用教育版Gsuite的edu邮箱白嫖教程

- Google Team Drive一枚,并且上面的Google Drive云盘账号是Google Team Drive团队盘的管理员,白嫖地址:传送门

环境配置

Python3安装

主要用于Autoclone的运行,其中Autorclone是一个python脚本,需要在Python3的环境运行,Python3目前只支持win7sp1以上系统的安装,当然不算liunx和mac系统,简单安装教程如下:

1下载Python3,双击安装,这里以python38为例

#最新版本的python3版本为python3.8 #WIN X64 https://www.python.org/ftp/python/3.8.3/python-3.8.3.exe #其他版本 https://www.python.org/ftp/python/

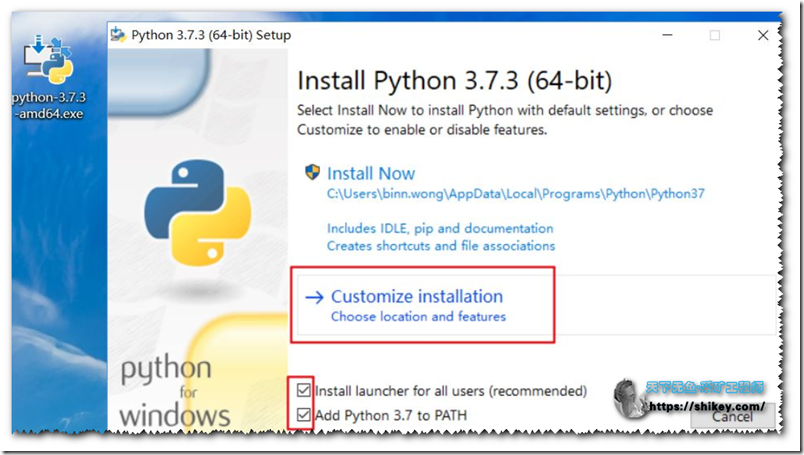

2安装注意事项,在安装过程中遇到是否添加系统变量(如下图,中文版的提示也是类似)一定选中!如果没有选中,请卸载了重新安装

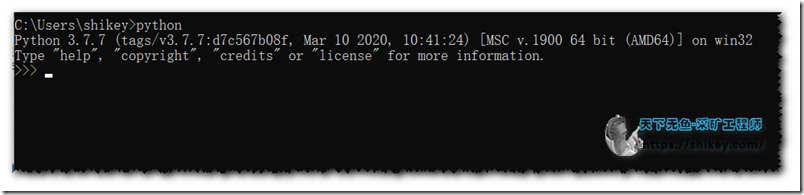

3尝试运行python

打开CMD或者是PowerShell,直接输入python,提示无误即代表成功,当然你安装的3.8,提示版本可能和我的不一样

退出命令:exit(),也可以直接关闭CMD窗口

winsfp安装

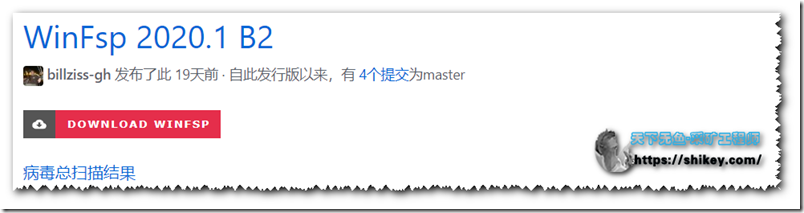

作用主要为rclone和gclone的运行环境,我没有装也可以使用,但是推荐一定要安装

下载地址,点击红色的那个下载直接安装,这个没有什么难度不做说明了

#下载地址-官方 http://www.secfs.net/winfsp/rel/ #下载地址-GitHub https://github.com/billziss-gh/winfsp/releases

插件源配置

打开当前文件夹CMD,输入

#升级下pip3 python -m pip install -U pip

按照插件

#按照需要的库 pip3 install -r requirements.txt

全局代理配置

直接确认自己全局可上的,本章可以直接跳过,博主已经测试了SSR和V2ray是无法直接使用的,利用传统VPN可以直接用.当然有些代理程序可以设置指定程序走代理,这些软件也是可以的.

本文采用SSR+Proxifier配置全局代理,具体可以参考这里:传送门,或者传送门2

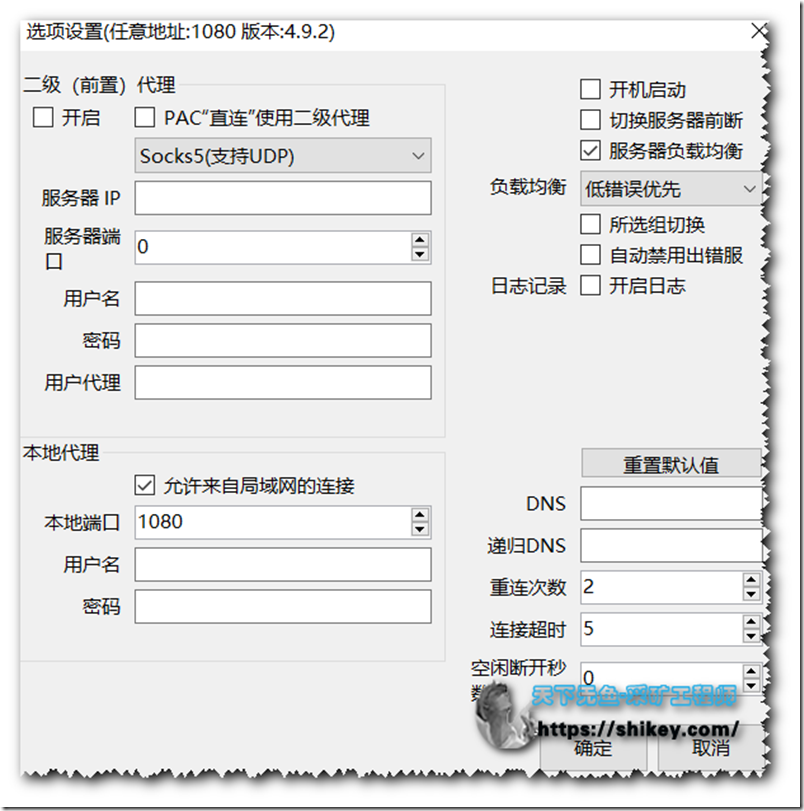

首先设置一下SSR

SSR|V2ray设置允许局域网连接,默认ssr是1080端口等,具体不会可以百度的

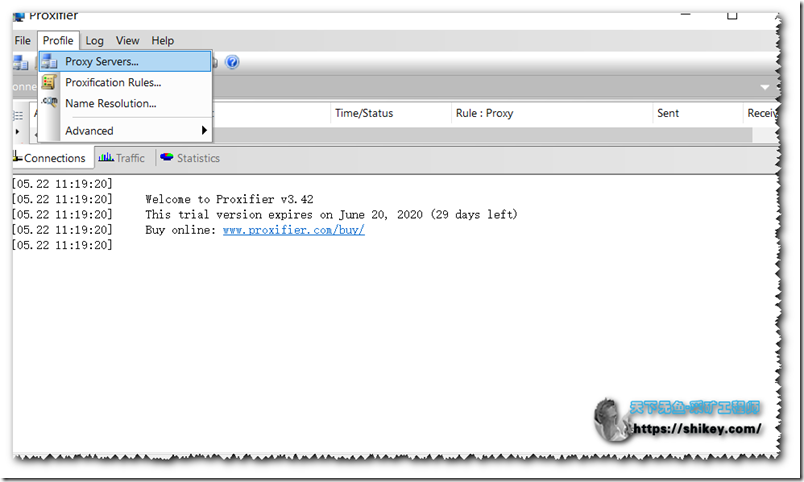

Proxifier下载及安装配置

#下载地址 https://www.proxifier.com/download/

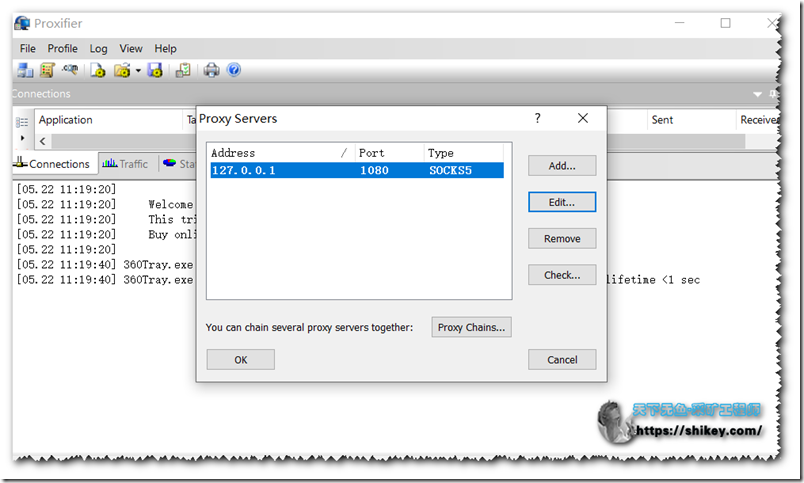

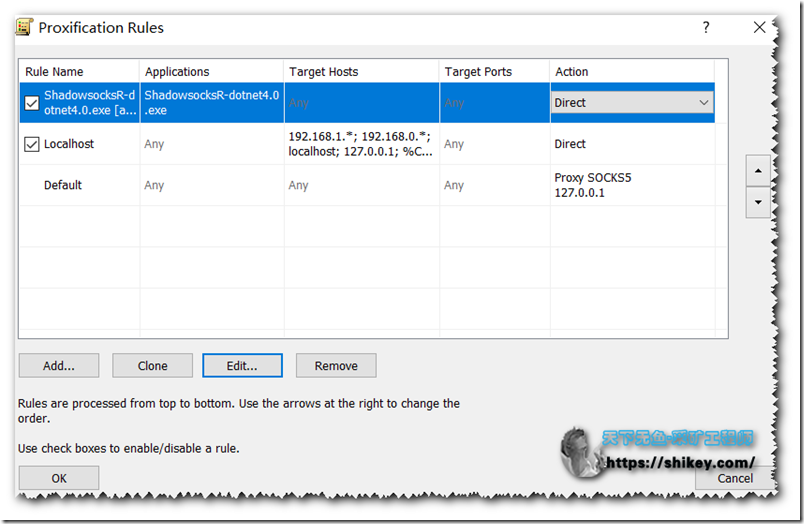

Proxifier设置,添加地址127.0.0.1,以及ss里配置的本地端口,默认为1080,选择socks version 5,check一下,绿色通过,红色你去检查下SSR设置及SSR是否可以正常工作

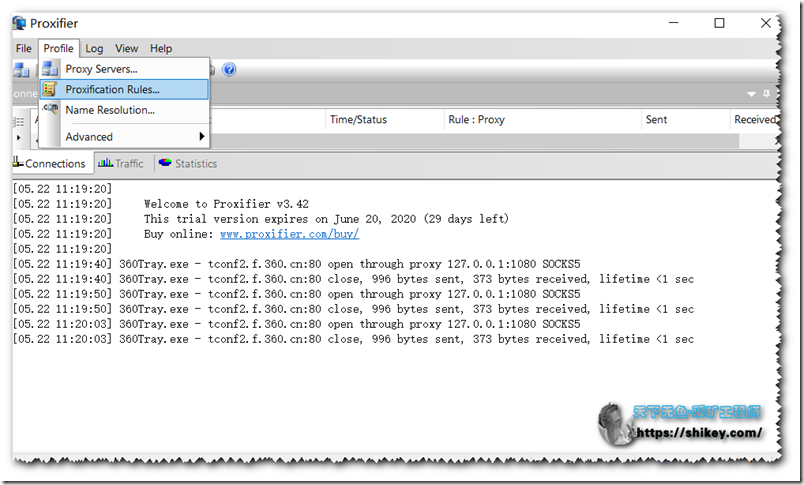

添加代理规则,建议使用白名单模式,局域网以外全部代理

最后打开IP138.COM,看看IP地址是否工作正常.

下载软件

软件有Rclone|Gclone|Autoclone把这个3个软件下载好直接丢到一个文件夹内操作会省心省事

#Rclone WIN64 https://downloads.rclone.org/v1.51.0/rclone-v1.51.0-windows-amd64.zip #Gclone WIN64 https://github.com/donwa/gclone/releases/download/v1.51.0-mod1.3.1/gclone_1.51.0-mod1.3.1_Windows_x86_64.zip #Autorclone https://codeload.github.com/xyou365/AutoRclone/zip/master #备用地址,新手集成包,我将所有环境软件全部拷贝打包好了,新手可以直接用我的这个,只支持WIN10 X64,不放心的可以从上面官方去考核,解压到统一目录 https://d.shikey.com/blog/jiaoben/gatc.7z

说明:其中理论上rclone是不用的,由于考虑我不太了解gclone的工作机制还是一起搞到一起把,另外考虑到dawan大佬好久不更新了,未来是够完全兼容还是另外一个问题,所以在本篇文章在长时间没有更新情况下,建议不要用太新版本的rclone,可能会有兼容性问题.

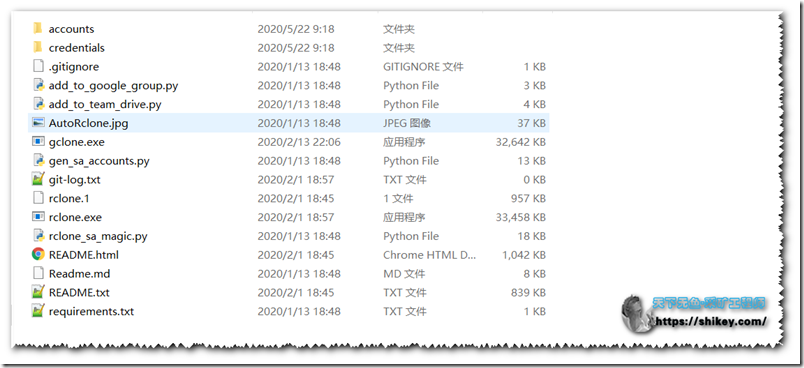

我们将以上地址解压到一个文件夹内,这个时候就可以正式开搞了,对比一下我的,不要漏文件和配置了,我这里解压路径为D:\gatc\

挂载GD

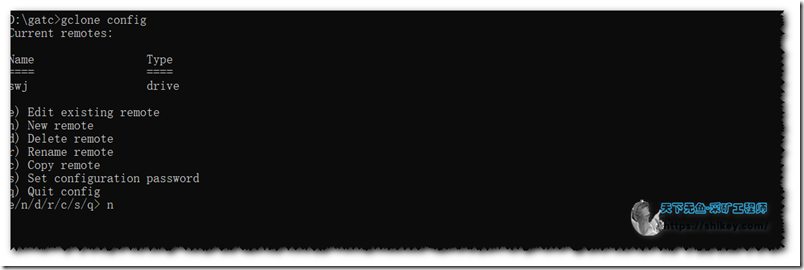

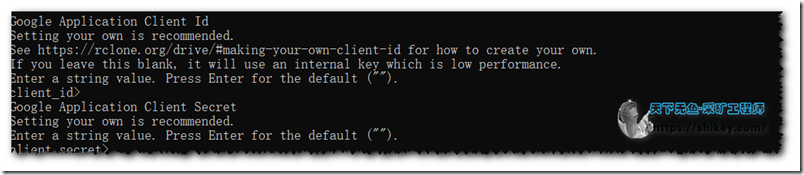

进入上述目录,输入rclone config或者gclone config开始配置

e) Edit existing remote n) New remote d) Delete remote r) Rename remote c) Copy remote s) Set configuration password q) Quit config e/n/d/r/c/s/q> n #输入n,新建一个网盘配置文件,将来调用要用到了,我已经建好了一个,swj,不要被我的图片误导

继续输入配置名称,我这里csr

选择挂载类型,我们这里说的是GD,所以选13

下面一直默认的走即可

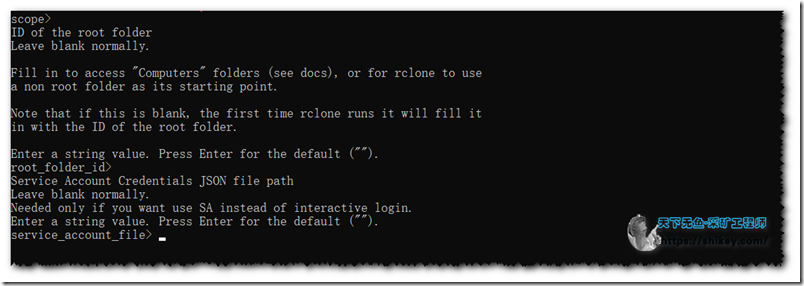

到这里,你可以把service_account_file_path直接写好,例如我这里的路径为D:\gatc\accounts,当然除了本文,正常挂载的话,你完全可以不用填写,以后需要再来编辑也可以的,我这里就不写了

新手建议不要配置了,以后需要再来编辑!

#Enter a string value. Press Enter for the default (""). service_account_file> #Service Account Credentials JSON file path . Enter a string value. Press Enter for the default (""). service_account_file_path> #我这里都是留空的

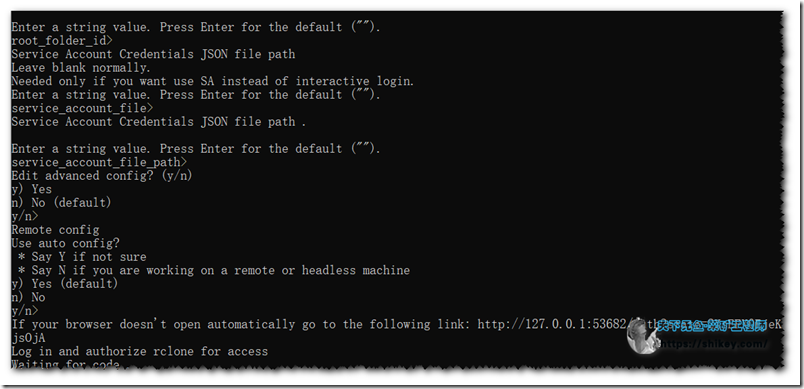

一路默认一直继续即可

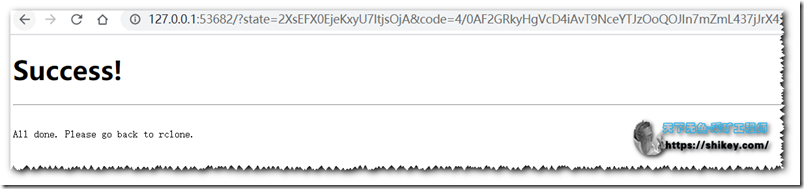

最后会在浏览器弹出登录信息,登录授权即可

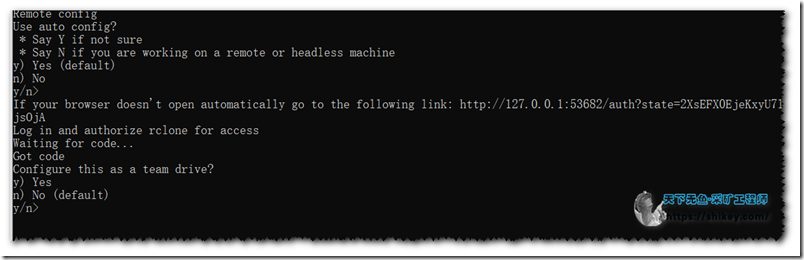

返回CMD,两个默认即可,这里挂载的是GD不是GTD,所以默认选n即可

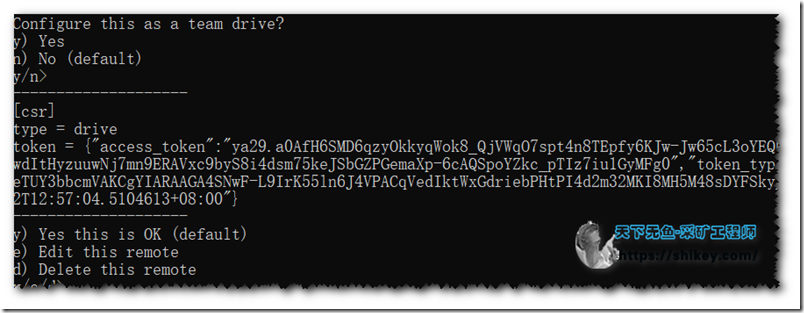

这个是token,记不记无所谓,都在config文件里面

这个时候多出了个csr,代表配置成功

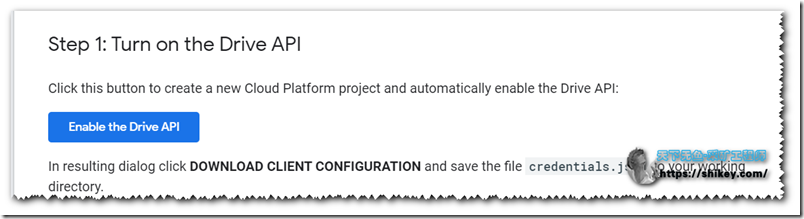

开启Google Python API授权

点击这里:传送门

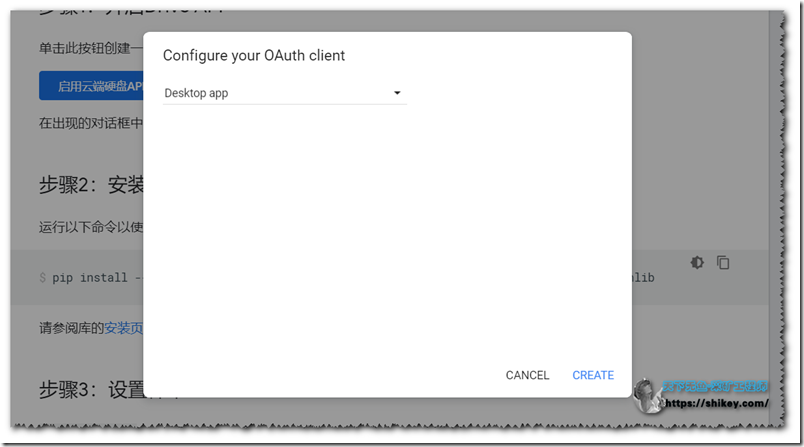

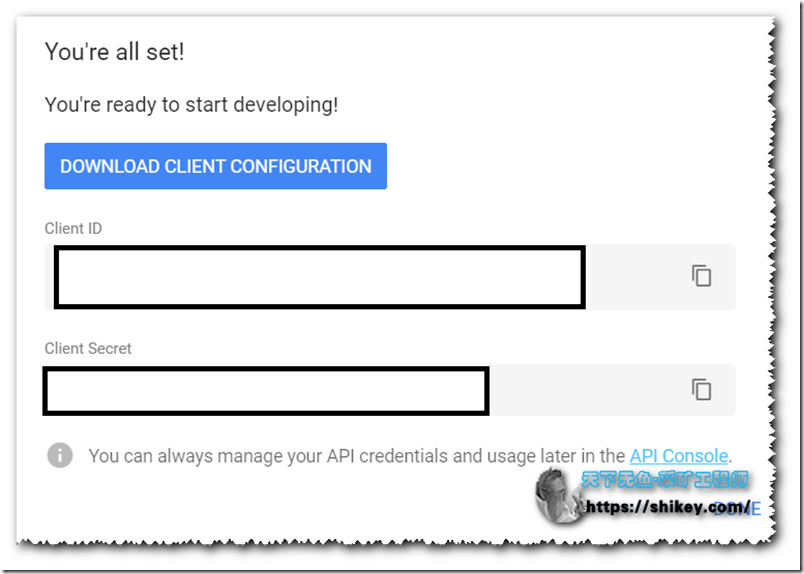

点击蓝色按钮,开启授权,点击create

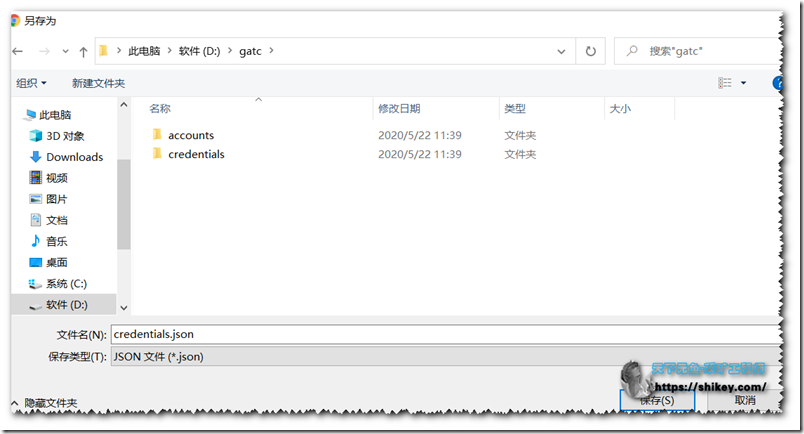

点击蓝色按钮,download ,将json文件下载到程序目录

批量生成服务号

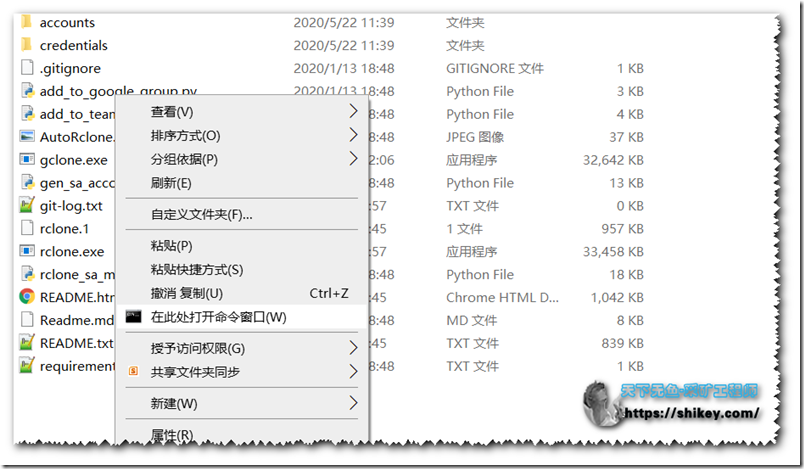

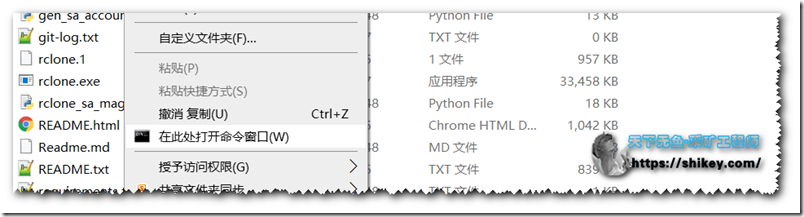

点击右键进入当前目录的CMD

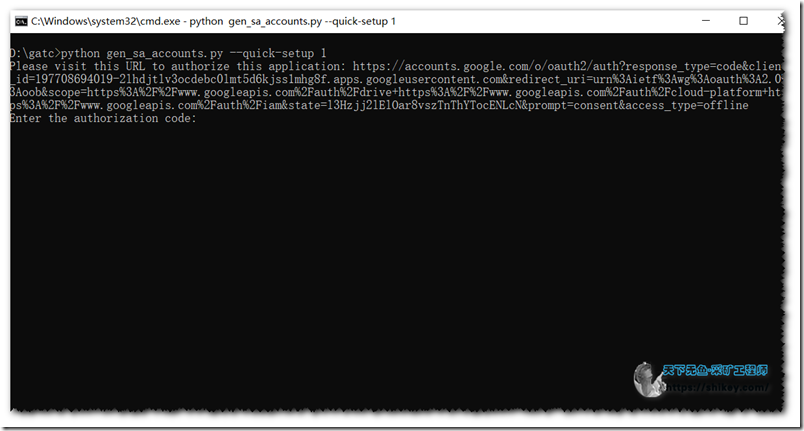

输入以下命令,开始批量创建服务号,这个时候会调用上述API,达到创建目的,你刚才登陆的账号和你挂载云盘的账号要是同一账号,并且TD盘也在该账号的名下,否则权限会出问题

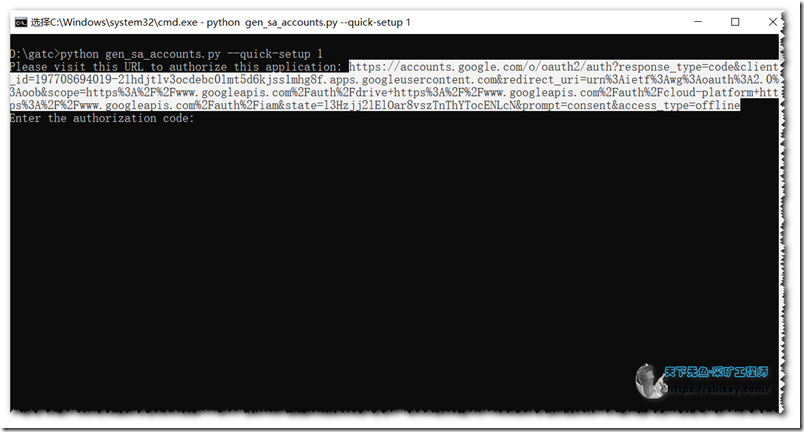

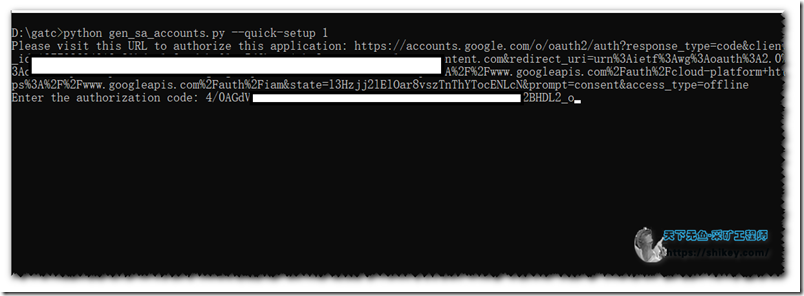

#最后一个1代表要创建的项目个数,其中1个项目有100个服务号,1个服务号可以有750G/天的流量,100个就是75T,你不够用就创建个2-4个,不要太多了,被封号就不值得了 python gen_sa_accounts.py --quick-setup 1

将改网址复制到浏览器去授权

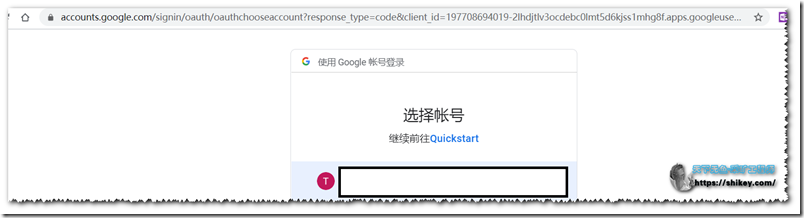

选择账号,点击高级,点击转至Quickstart(不安全

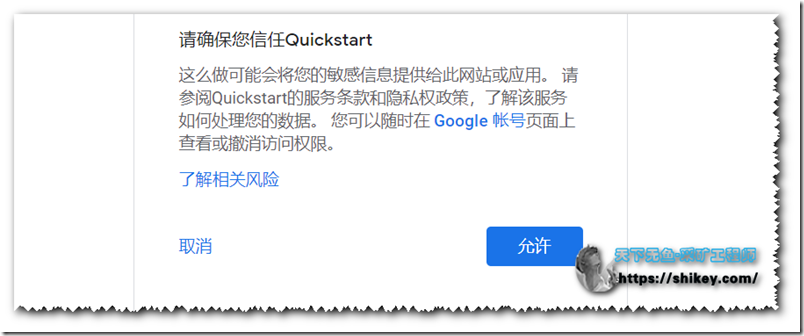

下面3个都允许

继续允许

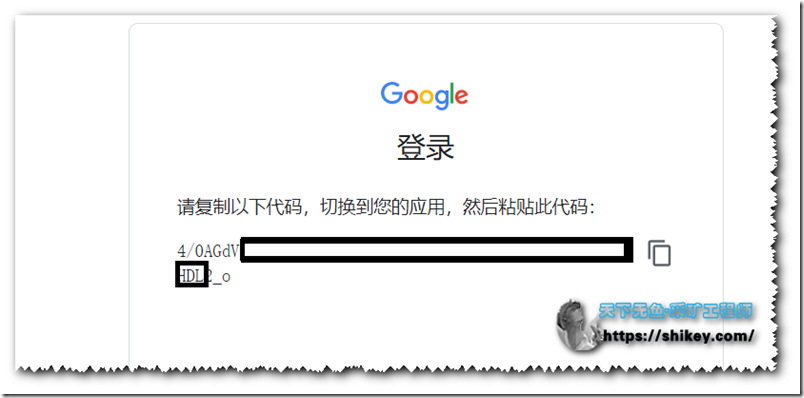

得到授权代码复制下来到CMD中

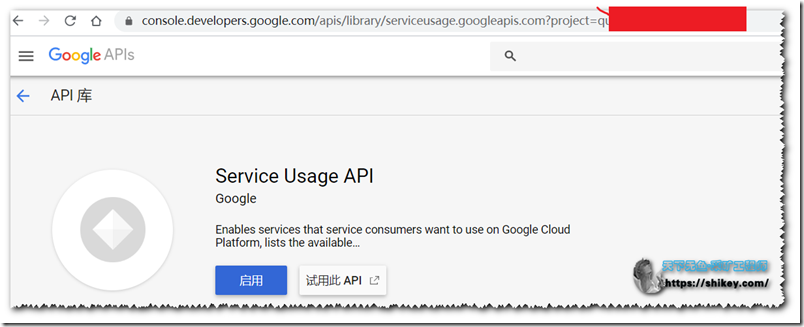

这个会提示一下Press Enter to retry,因为第一需要确认,所以复制以下,在浏览器中打开,启用API

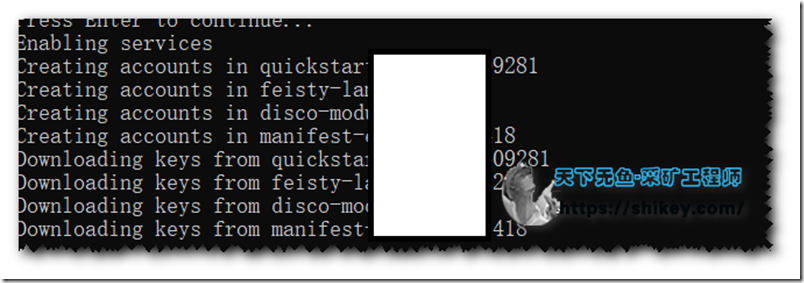

之后回到CMD,确认即可,过程大概几秒不等

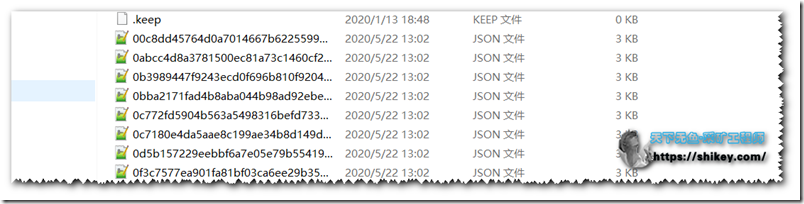

创建完成会在D:\gatc\accounts目录下多出100个json用户配置文件

服务号添加到团队盘

经过上面创建,服务号已经全部创建,相当于每个GD账号的权限,这个时候需要把这些服务号批量添加到团队盘中去,这样每个服务号就成了团队盘的成员,并都有了团队盘上传文件的权限

还是在CMD中使用以下命令进行批量添加:

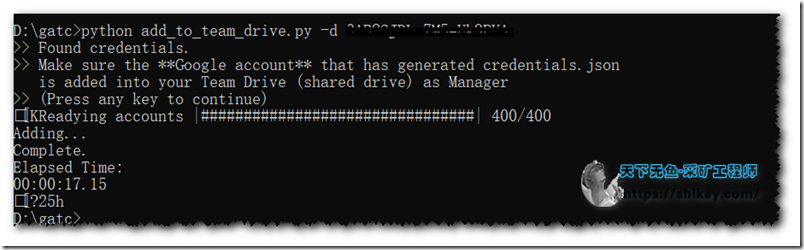

#其中SharedTeamDriveSrcID指的是你的团队盘ID,当然也可以是别人的团队盘,但是你在里面必须要全管理员权限啊,不然是添加不了的 python add_to_team_drive.py -d SharedTeamDriveSrcID

其中SharedTeamDriveSrcID就是下图画黑线的地方,注意这里是团队盘的ID,不是目录ID,搞错了是授权不了的

这里有个小插曲,不知道是我网络的问题,还是脚本API的原因,我在上面搞授权的时候没注意多点了一次retry,之后就会多出来1个项目,就是100个帐号,就是100个sa服务号,不影响使用,就是有点害怕被K

如上图基本成功了,这个时候打开你的团队盘,下面应该会多出100个用户,我多点了一次所以成了200,230个服务号,所以程序还是有一点的不稳定性啊

查看下成员,应该是下图,就基本上没问题了,记得权限是内容管理员,出错了证明脚本你没下载对

非必须:对了官方的推荐是创建一个论坛,之后把论坛添加到团队盘里面,这样用起来长久,具体操作:传送门,我觉得太麻烦了就没搞,动手能力强的小伙伴可以试试,当然也有工具可以把json里面的邮箱提取出来进行添加个人感觉,没有必要,保存好本地json授权文件用起来不一样吗

服务号配置到gclone中

这时候可以在CMD中手动配置,也可以查找config文件,用文本编辑器配置

打开CMD

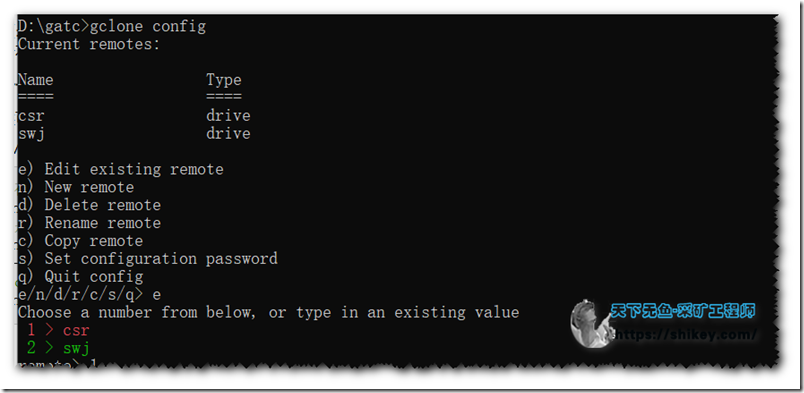

#直接在CMD里面编辑 gclone config #或者是下面命令都是一样的 rclone config ---------------------以下为文本编辑配置--------------------------------- #查找config文件位置,之后直接打开文件,在文本编辑器里面配置,麻烦 rclone config file

选择e编辑,选择1选选中csr

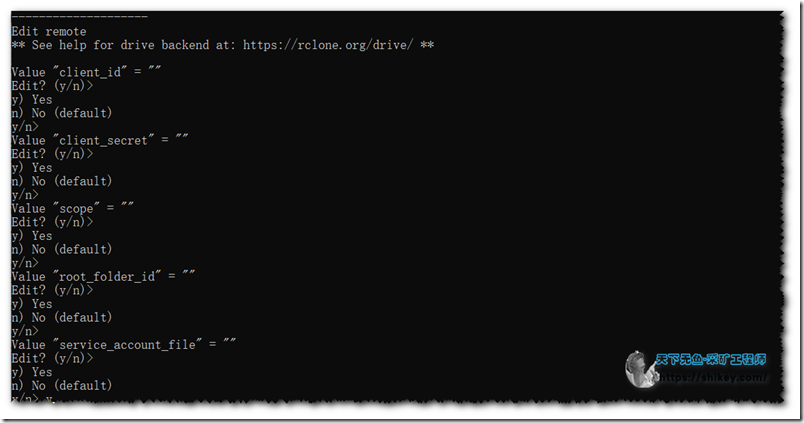

前面都是默认,一直到这个参数时候需要修改

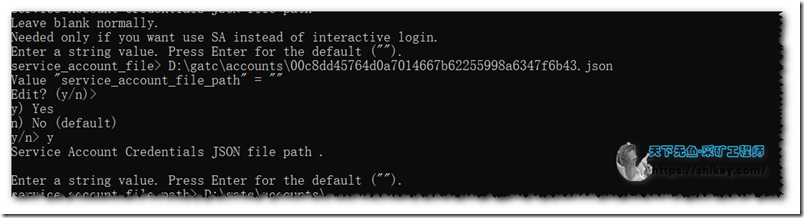

到这里选择Y,编辑参数service_account_file,这个时候填写你D:\gatc\accounts\xxxxx.json中任意一个json文件的完整路径,下面是一个示例

Value "service_account_file" = "" Edit? (y/n)> y) Yes n) No (default) y/n> y Service Account Credentials JSON file path Leave blank normally. Needed only if you want use SA instead of interactive login. Enter a string value. Press Enter for the default (""). service_account_file>D:\gatc\accounts\00c8dd45764d0a7014667b62255998a6347f6b43.json

继续,编辑service_account_file_ptch参数,选择D:\gatc\accounts\把”\”带上不然识别不了的

之后一路默认即可,另外这里,某些大神推荐是挂载团队盘,我个人感觉没必要,因为团队盘成员不一定有拷贝到个人盘的权限,不利于gclone的工作

#这里是否挂载为团队盘,个人认为没必要,很可能会报错,看你的选择把,我也不是非常肯定 Configure this as a team drive? y) Yes n) No (default) y/n>n

到此配置完毕,以下均为日常操作了,可惜的是在WIN10下均需要挂全局代理才可以,真心有点小麻烦哈,等我研究好了,再说,我曾经用SSR设置pac貌似成功了一次

gclone转存文件实例

其中目录ID是什么?例如

#别人共享你的网址 https://drive.google.com/drive/u/0/folders/1Fsw-8lXJsDLyTqWBY3GAaliOgHIt6L3A #目录ID就为蓝色的部分 1Fsw-8lXJsDLyTqWBY3GAaliOgHIt6L3A

在CMD中使用以下命令进行相关操作

#以下命令均参考官方https://github.com/donwa/gclone #共享文件拷贝到团队盘(挂载配置文件为csr),其中across为跳过重复文件 gclone copy csr:{共享目录id} csr:{团队盘目录id} --drive-server-side-across-configs #共享文件拷贝到团队盘(挂载配置文件为csr),显示转存进度 gclone copy csr:{共享目录id} csr:{团队盘目录id} --drive-server-side-across-configs -v #共享文件拷贝到团队盘下某一目录 gclone copy csr:{共享目录id} csr:{团队盘目录id} /子目录/ --drive-server-side-across-configs -v #共享文件拷贝到本人目录下,这个因为权限问题,所以只支持750G gclone copy csr:{共享目录id} csr:{本人云盘文件夹id} /子目录/ --drive-server-side-across-configs -v #团队盘拷贝到本人云盘下,这个是不需要流量的,你也可以直接在网页中拖放 gclone copy csr:{团队盘id} csr:{本人云盘文件夹id} /子目录/ --drive-server-side-across-configs -v #其他团队盘拷贝到本人团队盘,他人团队盘需要新增配置,并且授你帐号的权限,这里起名为csr1,这个如果理解不了,我只能打个简单比方,你去人家取东西,经过主人同意配把钥匙是应该的把 gclone copy csr1:{团队盘目录id} csr:{本人团队盘id} /子目录/ --drive-server-side-across-configs -v

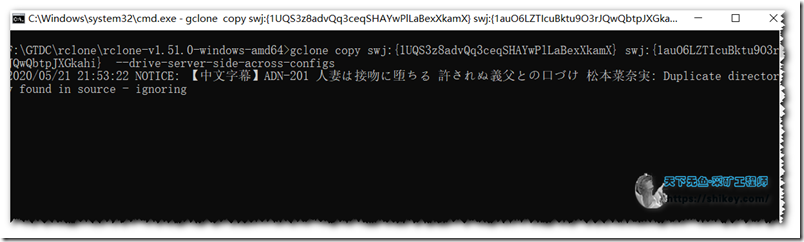

以下为自动切换帐号过程,突破750G,图是昨天的,今天没找到素材去更换呢,文件是干什么用的不是重点!不是重点!不是重点!这里只谈技术!

如何将文件转存到自己的云盘下?

将已经拷贝好在团队盘的文件,直接从团队盘拖入即可,使用gclone拖放也可以

或者使用gclone直接拷贝即可,我没试过后者!

注意事项

相关网址,以下你可能会用的到的

#dawan大佬gclone项目 https://github.com/donwa/gclone #Autorclone,不借助gclone也可以实现突破,但是容错率也较低 https://github.com/xyou365/AutoRclone #folderclone,这个也可以实现,我没研究,据说速度快,但是容错率低 https://github.com/Spazzlo/folderclone #rclone https://rclone.org/

实际上过程看起来复杂,但是原理搞明白了,其实很简单,win10系统下很重要的一点就是需要挂全局代理,这个小伙伴必须注意.将来操作也是需要挂全局的!!!!!!.

另外团队盘文件限制为40万个,记得定期清理和转存,不然也会报错

创建的项目个数失败 提示:

File "gen_sa_accounts.py", line 5, in

from google_auth_oauthlib.flow import InstalledAppFlow

ModuleNotFoundError: No module named 'google_auth_oauthlib'

全局扶墙了?

转存时出现错误 error reading source directory: directory not found

首先确认转存的源地址是否有效,之后看下语法

gclone copy csr:{共享目录id} csr:{共享目录id} --drive-server-side-across-configs

其中 csr 是的挂载配置名

C:\WINDOWS\system32>pip3 install -r requirements.txt

ERROR: Could not open requirements file: [Errno 2] No such file or directory: 'requirements.txt'

你首先要进入当前目录才可以直接运行,否则他识别不了路径的

大佬,问下你这wp的网站模板是什么,能否共享一下

https://github.com/vtrois/kratos